Слайсы в Go — один из самых мощных и удобных инструментов для работы с последовательностями данных. Однако, за их простотой скрывается коварная ловушка: неожиданное поведение, связанное с shared memory и копированием. Если вы когда-нибудь сталкивались с ситуацией, когда изменение одного слайса неожиданно меняло и другие, которые, казалось бы, были независимыми, то вы столкнулись с “грустным” слайсом. В этой статье мы разберемся, почему это происходит, и как избежать этой проблемы.

Понимание Shared Memory в Go

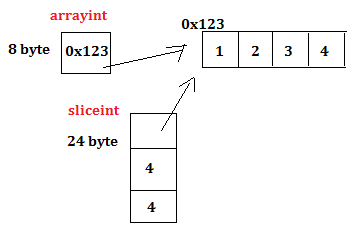

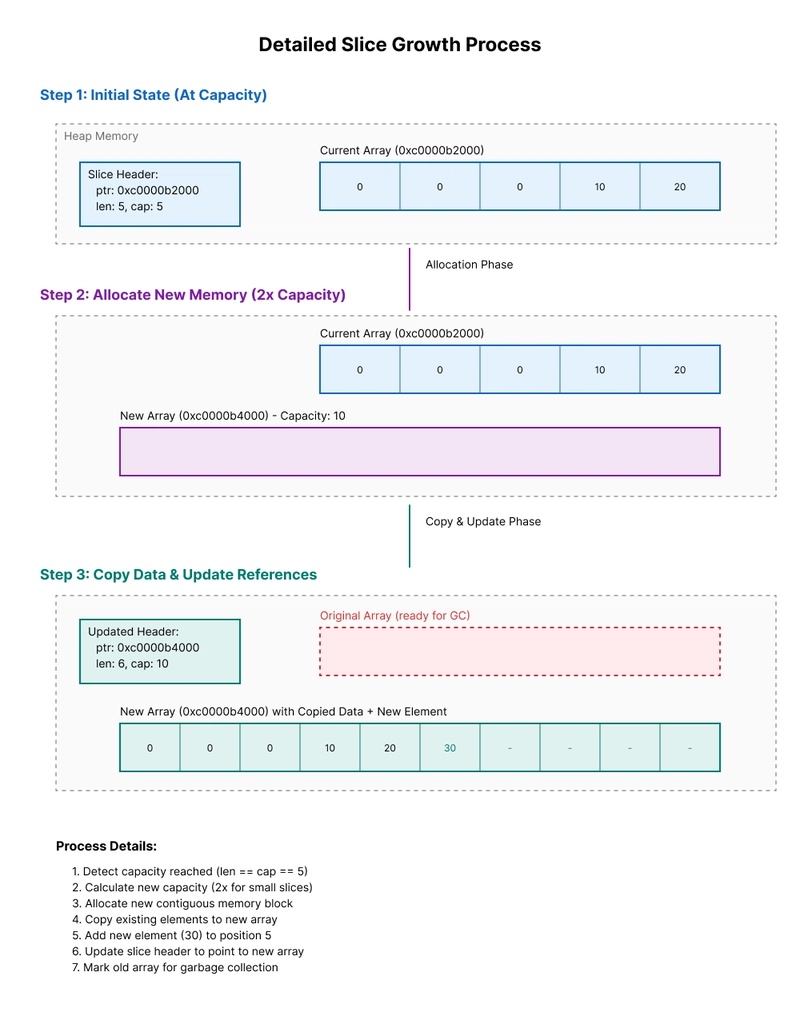

В Go, слайсы — это абстракции над массивами. Они не содержат сами данные, а лишь указывают на начало массива и его длину. Это означает, что несколько слайсов могут указывать на один и тот же массив. Когда вы создаете слайс из другого слайса (например, `newSlice := oldSlice[1:3]`), вы не создаете копию данных. Вместо этого `newSlice` получает указатель на ту же область памяти, что и `oldSlice`. Это делает операции с слайсами очень эффективными, но может привести к непредсказуемым результатам, если не понимать, как это работает.

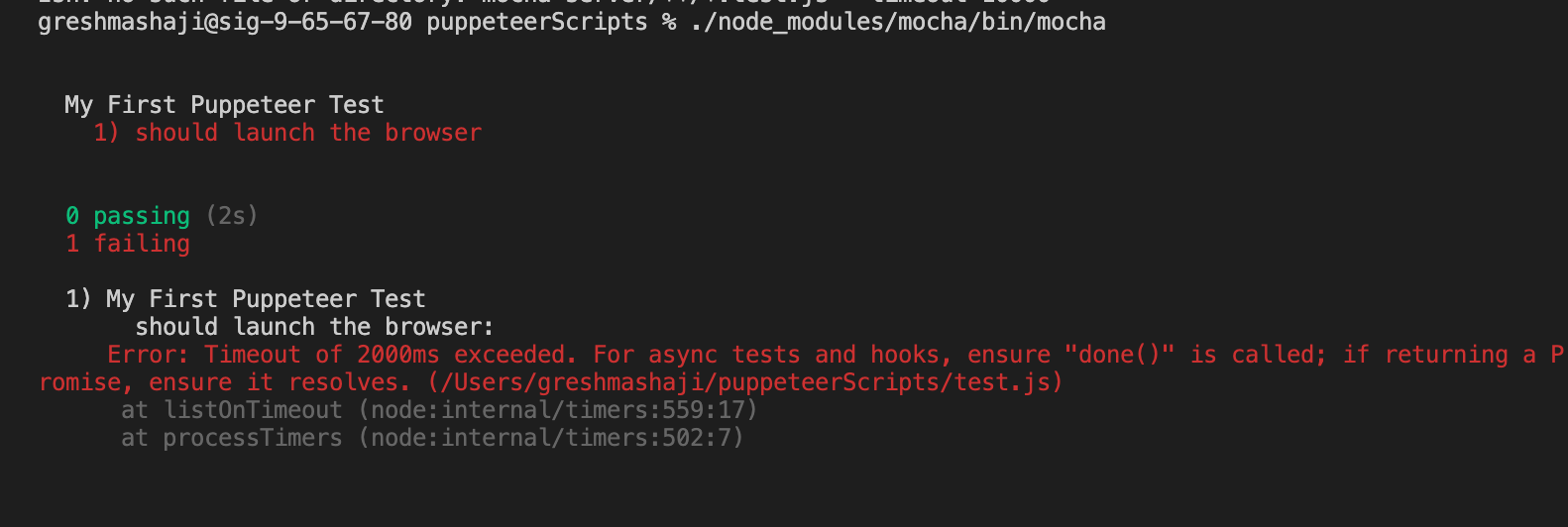

Рассмотрим следующий пример:

package main

import "fmt"

func main() {

originalSlice := []int{1, 2, 3, 3, 4, 3}

newSlice := originalSlice[1:3]

fmt.Println("Original:", originalSlice)

fmt.Println("New:", newSlice)

newSlice[0] = 100

fmt.Println("Original:", originalSlice)

fmt.Println("New:", newSlice)

}

Что произойдет, если вы запустите этот код? Вы увидите, что изменение `newSlice[0]` также изменило `originalSlice[1]`. Это потому, что оба слайса указывают на одну и ту же область памяти.

Как Избежать “Грустных” Слайсов: Копирование

Чтобы избежать этой проблемы, необходимо создавать копии данных, когда требуется независимый слайс. В Go существует несколько способов это сделать:

-

Использование встроенной функции `copy()`:

Это самый эффективный способ копирования слайсов. -

Создание нового слайса с указанием размера:

`newSlice := make([]int, len(oldSlice))` и последующее копирование данных. -

Использование `append()`:

`newSlice := append([]int{}, oldSlice)` (но будьте осторожны, это может быть менее эффективно для больших слайсов).

Вот пример использования функции `copy()`:

package main

import "fmt"

func main() {

originalSlice := []int{1, 2, 1, 2, 3, 2}

newSlice := make([]int, len(originalSlice))

copy(newSlice, originalSlice)

fmt.Println("Original:", originalSlice)

fmt.Println("New:", newSlice)

newSlice[0] = 100

fmt.Println("Original:", originalSlice)

fmt.Println("New:", newSlice)

}

Теперь изменение `newSlice[0]` не повлияет на `originalSlice`. Функция `copy()` создает полную копию данных, что позволяет слайсам быть полностью независимыми.

Оптимизация Использования Памяти

Копирование слайсов может быть дорогостоящей операцией, особенно для больших слайсов. Поэтому важно понимать, когда копирование действительно необходимо, а когда можно использовать shared memory. Если вы уверены, что слайсы не будут изменяться независимо друг от друга, то использование shared memory может значительно повысить производительность и снизить потребление памяти.

В некоторых случаях, можно использовать указатели на слайсы, чтобы передавать слайсы по ссылке, избегая копирования. Однако, это требует тщательного контроля за тем, кто и как изменяет слайс.

Слайсы и Функции

Важно помнить, что при передаче слайсов в функции, они передаются по ссылке. Если функция изменяет слайс, эти изменения будут видны вызывающему коду. Чтобы избежать этого, можно создать копию слайса внутри функции, прежде чем изменять его.

Например:

package main

import "fmt"

func modifySlice(slice []int) {

slice[0] = 100

}

func main() {

originalSlice := []int{1, 2, 3, 3, 4, 3}

modifySlice(originalSlice)

fmt.Println(originalSlice) // Output: [100 2 3 3 4 3]

}

Чтобы избежать изменения исходного слайса, можно создать копию слайса внутри функции:

package main

import "fmt"

func modifySlice(slice []int) {

copy(slice, slice) // Create a copy of the slice

slice[0] = 100

}

func main() {

originalSlice := []int{1, 2, 3, 3, 4, 3}

modifySlice(originalSlice)

fmt.Println(originalSlice) // Output: [1 2 3 3 4 3]

}

Заключение

Слайсы в Go — мощный инструмент, но понимание того, как они работают с shared memory, имеет решающее значение для написания эффективного и предсказуемого кода. Используйте функцию `copy()` для создания независимых слайсов, когда это необходимо, и будьте внимательны при передаче слайсов в функции. Соблюдая эти простые правила, вы сможете избежать “грустных” слайсов и писать более качественный Go код.

#go #slices #memory #programming #golang #performance #copy #sharedmemory