Распознавание Deepfakes: Увидеть обман сквозь пиксели

Эпоха цифровых технологий подарила нам беспрецедентные возможности для общения и доступа к информации. Однако вместе с прогрессом появились и новые вызовы, такие как Deepfakes – гиперреалистичные поддельные видео и аудио, созданные с использованием нейросетей. Распознавание Deepfakes становится жизненно важным навыком в современном мире, чтобы не стать жертвой дезинформации и манипуляций.

Как же отличить подлинное видео от Deepfake? Обратите внимание на следующие признаки:

-

Визуальные артефакты:

Ищите неестественные тени, размытость, искажения, особенно вокруг лица и волос. -

Неестественные движения:

Следите за мимикой и жестами. Deepfakes часто выдают себя неестественной, роботизированной анимацией. -

Несоответствия в звуке:

Обратите внимание на синхронизацию губ и речи. Часто в Deepfakes звук не соответствует движению губ. -

Отсутствие моргания:

Искусственный интеллект часто не учитывает естественные моргания. -

Низкое качество:

Хотя Deepfakes становятся все более реалистичными, некоторые все еще демонстрируют признаки низкого качества, такие как зернистость или отсутствие деталей.

Защита от манипуляций: Критическое мышление в эпоху Deepfakes

Простое распознавание Deepfakes – это только часть решения. Важно развивать навыки критической оценки информации в целом.

-

Проверяйте источник:

Откуда взято видео или аудио? Является ли источник надежным и проверенным? -

Перекрестная проверка:

Найдите подтверждение информации в других источниках. -

Ищите контекст:

Попробуйте понять цель создания видео или аудио. Кто выигрывает от распространения этой информации? -

Будьте скептичны:

Не верьте всему, что видите и слышите в интернете. -

Обращайте внимание на эмоции:

Эмоциональная реакция на контент может быть признаком манипуляции.

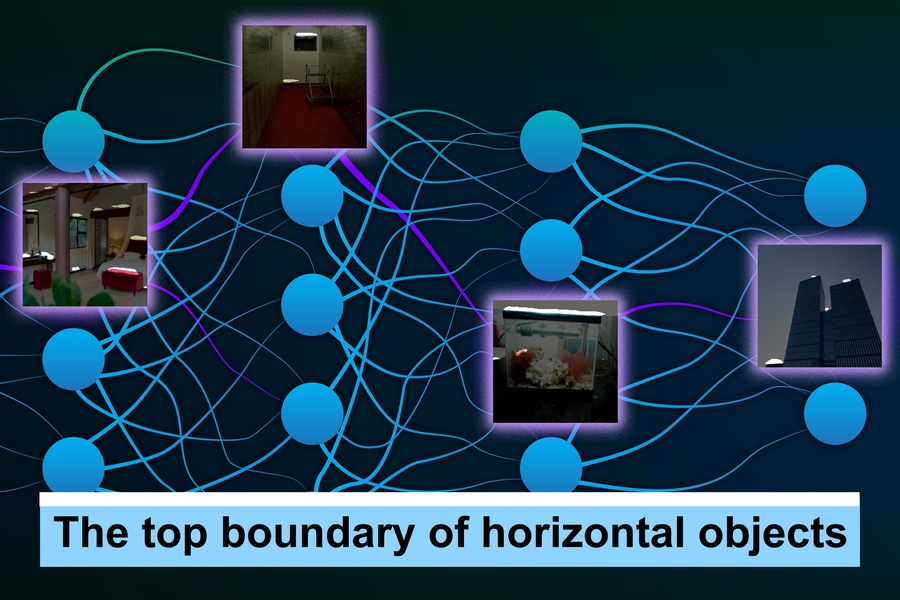

Понимание технологий: Нейросети и Deepfakes – как это работает

Чтобы эффективнее защищаться от Deepfakes, важно понимать, как они создаются. Deepfakes генерируются с использованием генеративно-состязательных сетей (GANs). В GANs две нейросети работают вместе: одна создает поддельные изображения или видео (генератор), а другая пытается отличить их от настоящих (дискриминатор). В процессе обучения генератор совершенствуется в создании все более реалистичных подделок, а дискриминатор – в их обнаружении. Этот процесс продолжается до тех пор, пока генератор не сможет создавать подделки, которые дискриминатор не может отличить от настоящих.

Инструменты и ресурсы: В помощь в борьбе с цифровым обманом

Существуют различные инструменты и ресурсы, которые могут помочь в выявлении Deepfakes:

-

Deepware Scanner:

Онлайн-сервис, который анализирует видео на наличие признаков Deepfake.

https://www.deepwareserver.com/deepfake-detector/

-

Sensity AI:

Платформа для обнаружения Deepfakes и фейковых изображений.

-

Fact-checking ресурсы:

Snopes, PolitiFact, AFP Fact Check – проверьте информацию на этих ресурсах.

Влияние на общество: Этика и ответственность в эпоху искусственного интеллекта

Распространение Deepfakes представляет серьезную угрозу для общества. Они могут быть использованы для дезинформации, клеветы, политических манипуляций и даже шантажа. Важно помнить, что создание и распространение Deepfakes без согласия изображенных лиц является незаконным и неэтичным. Разработчики технологий искусственного интеллекта несут ответственность за предотвращение их использования во вред обществу.

Будущее борьбы: Технологии аутентификации и детекторы Deepfakes

Исследователи разрабатывают новые методы борьбы с Deepfakes. Среди них:

-

Водяные знаки:

Внедрение невидимых водяных знаков в цифровые изображения и видео для проверки их подлинности. -

Технологии аутентификации:

Разработка систем, которые могут подтвердить, что видео или аудио действительно создано конкретным человеком или устройством. -

Улучшенные детекторы Deepfakes:

Постоянное совершенствование алгоритмов обнаружения Deepfakes для борьбы с новыми и более продвинутыми технологиями.

#deepfake #нейросети #искусственныйинтеллект #безопасность #factchecking #технологии #кибербезопасность #дезинформация #критическоемышление

Добавить комментарий