Что такое AI-галюцинации?

Искусственный интеллект, особенно большие языковые модели (LLM), стремительно проникает во все сферы нашей жизни. Но вместе с их впечатляющими возможностями возникают и новые вызовы, один из которых – AI-галлюцинации. Что же это такое? Галлюцинации в контексте ИИ – это выдача нейросетью информации, которая выглядит правдоподобной и даже убедительной, но при этом не имеет под собой никакой фактической основы. Это не просто ошибка в расчетах; это создание выдуманных фактов, событий или источников.

Представьте, что вы задаете нейросети вопрос о влиянии космических лучей на урожайность пшеницы, а она выдает вам статью, ссылаясь на несуществующего профессора из Университета Оксфорда. Звучит солидно, но это – галлюцинация.

Причины AI-галлюцинаций

Галлюцинации – не случайное явление. Они обусловлены целым рядом факторов:

-

Недостаток данных:

Модели обучаются на огромных объемах информации, но даже самым большим датасетам свойственны пробелы. Когда модель сталкивается с запросом, по которому у нее нет достаточных данных, она может начать “додумывать”. -

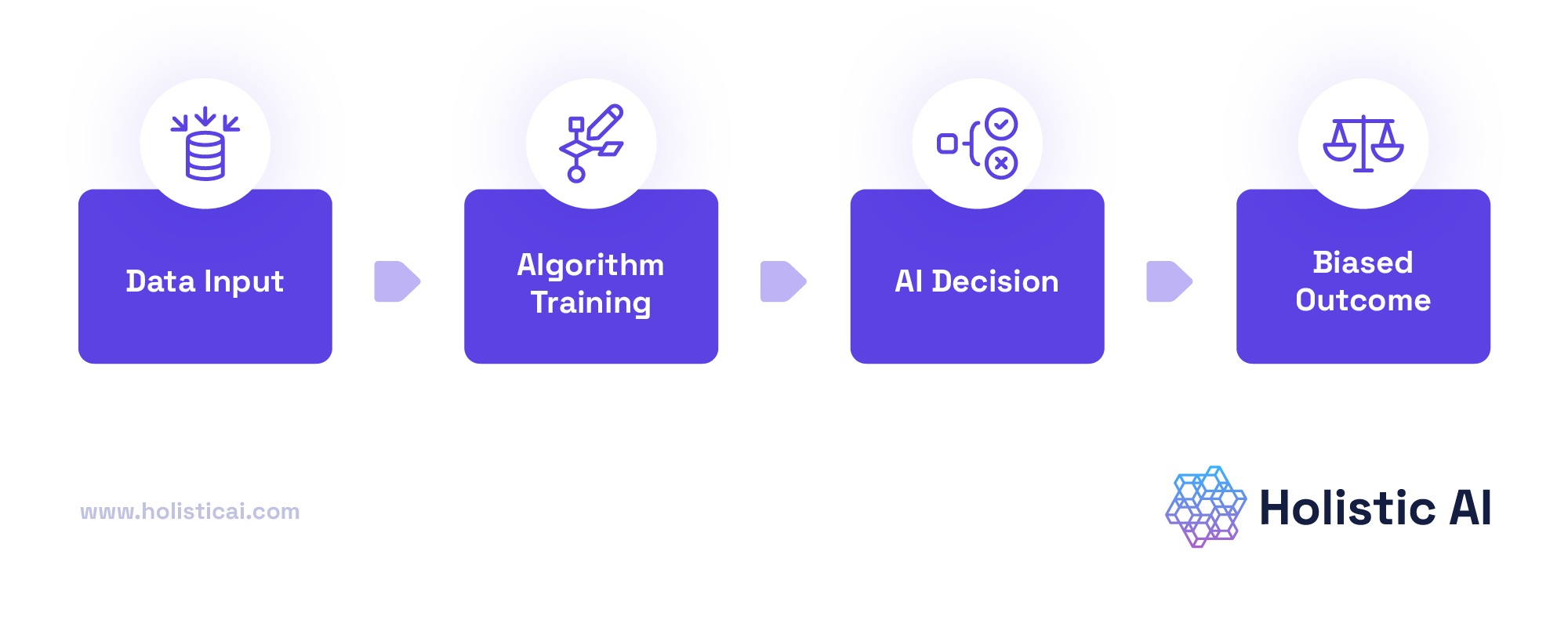

Предвзятость в данных:

Если данные, на которых обучалась модель, содержат предвзятую информацию (например, стереотипы), модель может воспроизводить и усиливать эту предвзятость в своих ответах. -

Сложные запросы:

Чем сложнее и неоднозначнее запрос, тем больше вероятность того, что модель “сбится” с пути и начнет генерировать галлюцинации. -

Архитектурные ограничения модели:

Некоторые архитектуры моделей, особенно те, которые оптимизированы для генерации текста, а не для поиска фактов, более склонны к галлюцинациям. -

Оптимизация для плавности, а не для точности:

Многие модели нацелены на генерацию связного и логичного текста, даже если это означает жертву точности.

Последствия AI-галюцинаций

Галлюцинации – это не просто забавная особенность ИИ. Они могут иметь серьезные последствия:

-

Дезинформация:

Галлюцинации могут распространять ложную информацию, что может ввести людей в заблуждение. -

Неправильные решения:

Если решения принимаются на основе информации, полученной от ИИ, галлюцинации могут привести к ошибочным и даже опасным действиям. -

Подрыв доверия к ИИ:

Чем чаще ИИ выдает галлюцинации, тем меньше люди будут ему доверять, что может замедлить внедрение ИИ в различных отраслях. -

Юридические последствия:

Выдача ложной информации может привести к юридическим претензиям.

Методы обнаружения галлюцинаций

К счастью, существуют способы выявить ложную информацию, генерируемую ИИ:

-

Перекрестная проверка:

Сравнение информации, полученной от ИИ, с другими источниками. -

Анализ “уверенности” модели:

Некоторые модели предоставляют оценку своей уверенности в правильности ответа. Низкая уверенность может быть признаком галлюцинации. -

Использование специализированных инструментов:

Появляются инструменты, разработанные специально для выявления и исправления галлюцинаций в текстах, сгенерированных ИИ. -

Оценка источника:

Проверка, существуют ли источники, на которые ссылается модель, и соответствуют ли они заявленной информации.

Стратегии снижения галлюцинаций

Совершенно избежать галлюцинаций на текущем уровне развития ИИ невозможно, но существуют стратегии для их уменьшения:

-

Улучшение качества данных:

Обучение моделей на более качественных и проверенных данных. -

Разработка более надежных архитектур моделей:

Исследование и разработка архитектур, которые менее склонны к галлюцинациям. -

Использование техник обучения с подкреплением на основе обратной связи от человека:

Обучение моделей на основе обратной связи от людей, которые могут указывать на галлюцинации. -

Включение механизмов самокритики:

Разработка моделей, способных оценивать и исправлять собственные ошибки. -

Усиление точности, а не только плавности:

Переориентация при обучении на точность, а не только на плавность и связность текста.

Будущее борьбы с галлюцинациями

Исследования в области борьбы с AI-галлюцинациями активно продолжаются. Ожидается:

-

Разработка новых метрик оценки:

Необходимы более точные метрики для оценки точности и надежности моделей. -

Создание инструментов для отладки моделей:

Появятся инструменты, которые помогут разработчикам выявлять и устранять причины галлюцинаций. -

Развитие “честных” моделей ИИ:

Акцент будет сделан на создание моделей, которые не только генерируют текст, но и способны объяснять, почему они сделали тот или иной вывод.

#AI #AIгаллюцинации #нейросети #ИИ #технологии #искусственныйинтеллект #machinelearning #deeplearning #AIethics

Добавить комментарий