Вы тратите часы на повторяющиеся задачи? Переименование файлов, обработка данных, отправка отчетов – кажется, что это никогда не закончится? Python может стать вашим спасителем! Эта статья для тех, кто только начинает свой путь в программировании и хочет автоматизировать рутинные задачи, о которых даже не подозревал. Мы покажем, как с помощью Python можно существенно экономить время и повысить производительность, даже не имея глубоких знаний программирования.

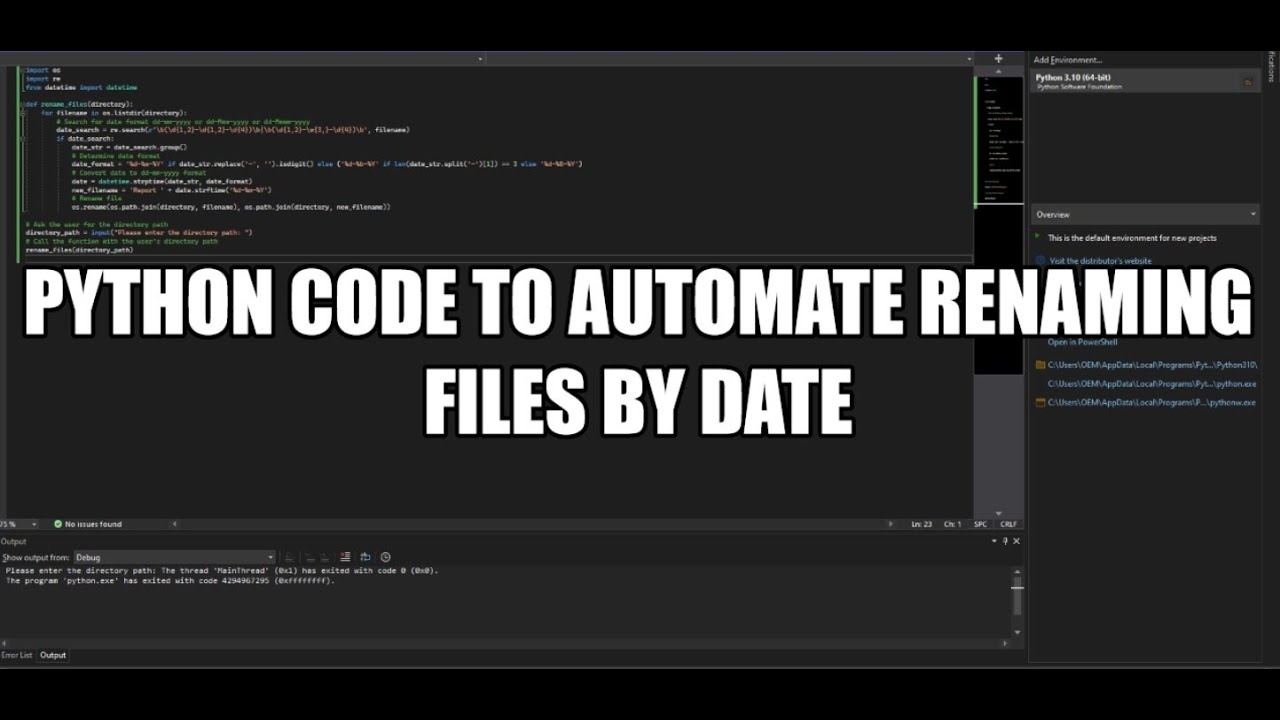

Автоматизация работы с файлами

Одна из самых простых задач для автоматизации – это работа с файлами. Например, представьте, что вам нужно переименовать сотни фотографий, добавив к ним дату съемки. Вручную это займет уйму времени. Python позволяет сделать это в несколько строк кода:

import os

import datetime

def rename_files(directory):

for filename in os.listdir(directory):

if filename.endswith(".jpg"):

date_string = datetime.datetime.now().strftime("%Y%m%d")

new_name = filename.replace(".jpg", "_" + date_string + ".jpg")

old_path = os.path.join(directory, filename)

new_path = os.path.join(directory, new_name)

os.rename(old_path, new_path)

print(f"Переименован: {filename} -> {new_name}")

rename_files("/путь/к/директории")

Этот скрипт перебирает все файлы с расширением “.jpg” в указанной директории и добавляет к ним текущую дату в формате ГГГГММДД. Вы можете легко адаптировать его для других расширений и форматов дат.

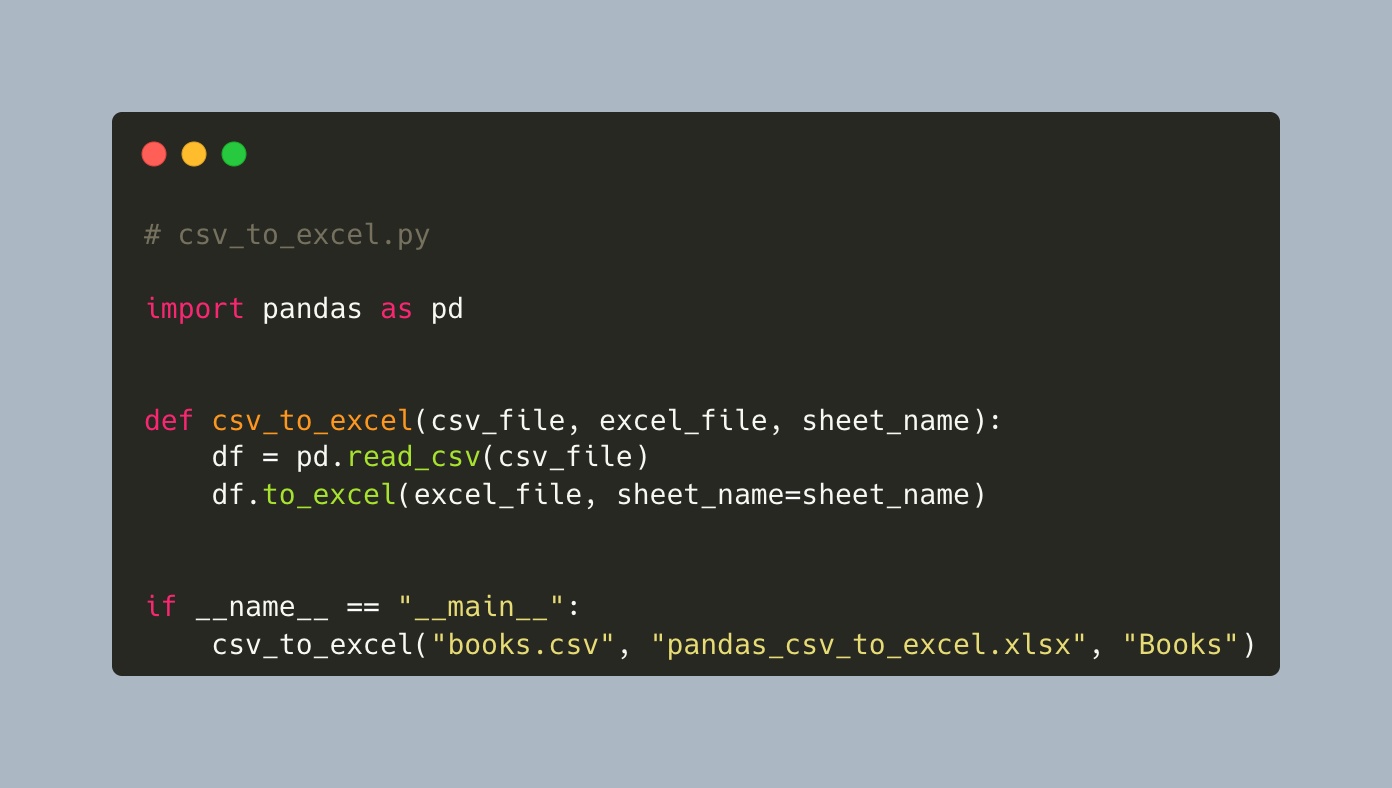

Работа с Excel: из хаоса в порядок

Обработка данных в Excel – еще одна область, где Python может прийти на помощь. Вместо того, чтобы вручную копировать и вставлять данные, вы можете написать скрипт, который автоматически выполнит необходимые операции.

import pandas as pd

# Чтение данных из Excel

df = pd.read_excel("data.xlsx")

# Выполнение операций над данными (например, удаление строк с пропущенными значениями)

df = df.dropna()

# Сохранение обработанных данных в новый Excel-файл

df.to_excel("processed_data.xlsx", index=False)

Здесь мы используем библиотеку Pandas, которая является мощным инструментом для работы с табличными данными. Скрипт читает данные из файла “data.xlsx”, удаляет строки с пропущенными значениями и сохраняет обработанные данные в файл “processed_data.xlsx”. Pandas предлагает огромный набор функций для фильтрации, сортировки, агрегации и визуализации данных.

Автоматическая отправка электронных писем

Представьте, что вам нужно регулярно отправлять отчеты или уведомления определенной группе людей. Вместо того, чтобы вручную копировать и вставлять текст в каждое письмо, вы можете автоматизировать этот процесс с помощью Python.

import smtplib

from email.mime.text import MIMEText

def send_email(sender_email, sender_password, receiver_email, subject, body):

msg = MIMEText(body)

msg['Subject'] = subject

msg['From'] = sender_email

msg['To'] = receiver_email

with smtplib.SMTP_SSL('smtp.gmail.com', 465) as smtp:

smtp.login(sender_email, sender_password)

smtp.sendmail(sender_email, receiver_email, msg.as_string())

send_email("[email protected]", "your_password", "[email protected]", "Отчет", "Привет! Это автоматический отчет.")

Этот скрипт отправляет электронное письмо с использованием протокола SMTP. Вам потребуется настроить параметры SMTP-сервера и указать свои учетные данные. Обязательно включите двухфакторную аутентификацию и разрешите доступ для менее безопасных приложений в настройках вашей почты.

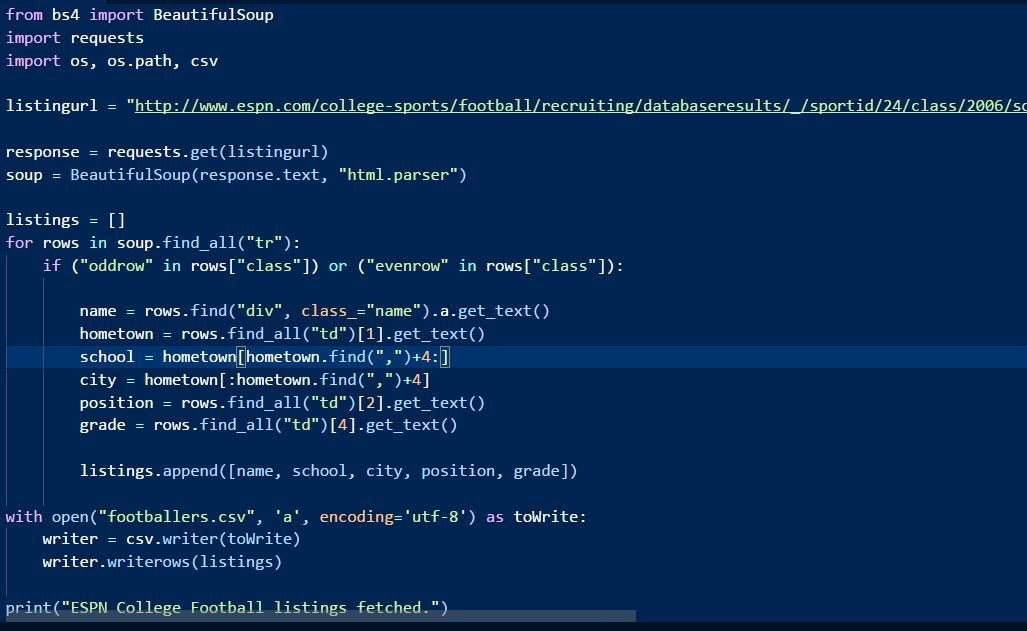

Веб-скрейпинг: извлечение данных из интернета

Веб-скрейпинг – это извлечение данных с веб-сайтов. Это может быть полезно для сбора информации о ценах, новостях или любых других данных, которые вам нужны. Библиотека Beautiful Soup упрощает процесс парсинга HTML и XML.

import requests

from bs4 import BeautifulSoup

url = "https://www.example.com"

response = requests.get(url)

soup = BeautifulSoup(response.content, ".parser")

# Извлечение заголовков

titles = soup.find_all("h2")

for title in titles:

print(title.text)

Этот скрипт отправляет HTTP-запрос к указанному URL-адресу, получает HTML-контент и использует Beautiful Soup для парсинга HTML. Затем он извлекает все заголовки уровня “h2” и выводит их на экран.

Начало работы: простые шаги

-

Установите Python:

Скачайте и установите Python с официального сайта

python.org

. -

Установите библиотеки:

Используйте `pip` (менеджер пакетов Python) для установки необходимых библиотек, например:- `pip install pandas`

- `pip install beautifulsoup4`

- `pip install requests`

-

Начните с малого:

Не пытайтесь сразу написать сложный скрипт. Начните с простых задач и постепенно усложняйте их. -

Изучайте документацию:

Каждая библиотека имеет свою документацию, которая содержит примеры и объяснения. -

Практикуйтесь:

Чем больше вы практикуетесь, тем лучше вы будете понимать, как работает Python.

Автоматизация рутинных задач с помощью Python – это мощный способ повысить производительность и сэкономить время. Не бойтесь экспериментировать и пробовать новые вещи. Даже если вы новичок в программировании, вы можете начать автоматизировать свои задачи уже сегодня!

#python #автоматизация #программирование #полезныесоветы #новичкам #pandas #beautifulsoup #webscraping

Добавить комментарий