Python и Большие Языковые Модели: Синергия для Ускорения Разработки

В эпоху бурного развития искусственного интеллекта, особенно с появлением больших языковых моделей (LLM), таких как GPT-3, PaLM и LLaMA, скорость разработки становится критически важным фактором. Python, благодаря своей простоте, читаемости и огромной экосистеме библиотек, зарекомендовал себя как идеальный язык для работы с LLM. Эта статья рассмотрит, как Python ускоряет разработку приложений на базе LLM на всех этапах – от быстрого прототипирования до масштабируемого развертывания.

Прототипирование и Эксперименты: Быстрый Старт с Python

Начальный этап разработки часто включает в себя множество экспериментов с API LLM. Python позволяет быстро создавать прототипы и тестировать различные подходы. Благодаря простоте синтаксиса и доступности библиотек, можно легко интегрировать LLM в свои приложения.

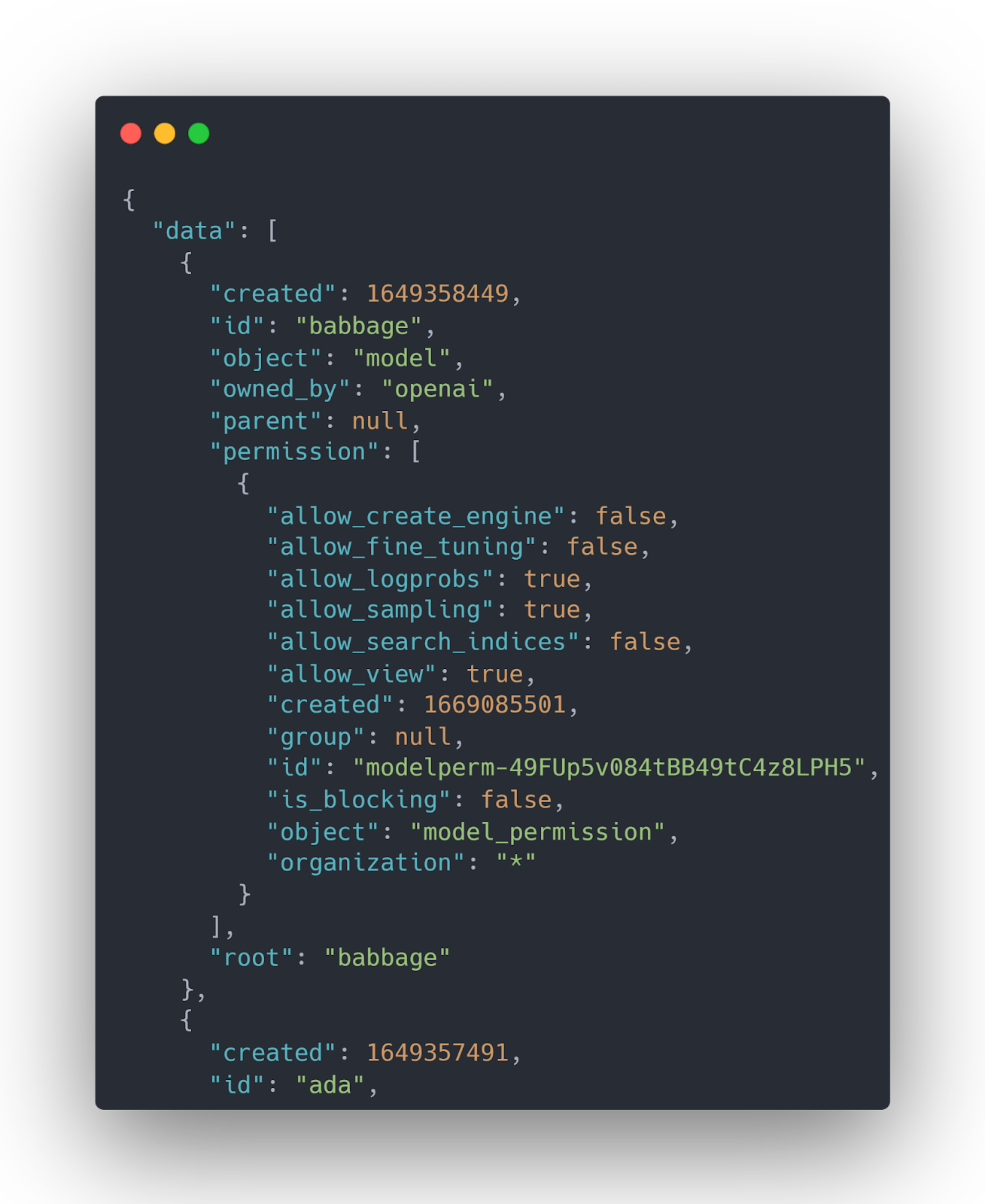

OpenAI API и Python: Идеальный Дуэт

Работа с OpenAI API, одним из самых популярных способов доступа к LLM, становится тривиальной с помощью библиотеки `openai`. Установка проста: `pip install openai`. Вот пример простого запроса к GPT-3:

import openai

openai.api_key = "YOUR_API_KEY"

response = openai.Completion.create(

engine="text-davinci-003",

prompt="Напиши короткое стихотворение о котах.",

max_tokens=60

)

print(response.choices[0].text)

Этот код демонстрирует, как легко отправлять запрос к модели и получать ответ. Python позволяет быстро итерировать, изменяя параметры запроса (engine, prompt, max_tokens, temperature и т.д.) и оценивать результаты.

LangChain: Фреймворк для Сложных LLM-приложений

Для разработки более сложных приложений, требующих цепочек запросов, управления памятью и интеграции с внешними источниками данных, LangChain становится незаменимым инструментом. LangChain предоставляет абстракции и компоненты для создания мощных LLM-приложений, таких как чат-боты, агенты и системы извлечения информации.

LangChain упрощает взаимодействие с различными LLM (OpenAI, Cohere, Hugging Face), предоставляет инструменты для управления памятью (memory) и позволяет интегрировать LLM с базами данных и другими сервисами.

Разработка и Оптимизация: Улучшение Производительности и Качества

После успешного прототипирования приходит этап разработки, где важна не только функциональность, но и производительность и качество. Python предоставляет инструменты для профилирования кода, оптимизации запросов к LLM и улучшения качества генерируемого текста.

Профилирование и Оптимизация

Python позволяет использовать инструменты профилирования, такие как `cProfile`, для выявления узких мест в коде и оптимизации производительности. Важно оптимизировать запросы к LLM, например, путем кэширования результатов или использования более эффективных промптов.

Оценка Качества и Prompt Engineering

Оценка качества генерируемого текста является критически важной. Python позволяет автоматизировать этот процесс, используя метрики, такие как BLEU, ROUGE и BERTScore. Prompt engineering, искусство создания эффективных промптов, также играет важную роль в улучшении качества результатов. Библиотеки, такие как `prompttools`, помогают в этом.

Развертывание и Масштабирование: Готовим Приложение к Производству

Развертывание LLM-приложений может быть сложной задачей, особенно при больших нагрузках. Python предоставляет инструменты для контейнеризации, оркестрации и мониторинга.

Контейнеризация с Docker

Docker позволяет упаковать приложение и все его зависимости в контейнер, обеспечивая воспроизводимость и упрощая развертывание. Python-приложения легко контейнеризируются с использованием Docker.

Оркестрация с Kubernetes

Kubernetes позволяет автоматизировать развертывание, масштабирование и управление контейнеризированными приложениями. Python-приложения, развернутые в Docker-контейнерах, могут быть легко оркестрированы с помощью Kubernetes.

Мониторинг и Логирование

Мониторинг производительности и логирование ошибок являются критически важными для поддержания стабильности LLM-приложений. Python предоставляет библиотеки, такие как `Prometheus` и `Grafana`, для мониторинга и визуализации метрик.

Заключение

Python, благодаря своей простоте, гибкости и богатой экосистеме библиотек, является незаменимым инструментом для разработки приложений на базе больших языковых моделей. От быстрого прототипирования до масштабируемого развертывания, Python ускоряет процесс разработки и позволяет создавать мощные и эффективные LLM-приложения. Постоянное развитие Python и его библиотек обещает еще более широкие возможности для работы с LLM в будущем.

#python #llm #ai #разработка #openai #langchain #развертывание #docker #kubernetes #promptengineering

Добавить комментарий